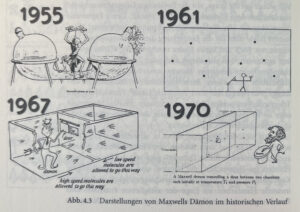

Die Information ist also ein Maß für einen Zustand der Gleichwahrscheinlichkeit, für eine gleichförmige statistische Verteilung an der Quelle; und dieser statistische Wert ist jener, den die Informationstheoretiker in Anlehnung an die Thermodynamik als Entropie bezeichnen. [☞ 1] Die Entropie eines Systems ist der Zustand der Gleichwahrscheinlichkeit, dem seine Elemente zustreben. Die Entropie kann auch definiert werden als ein Zustand der Unordnung in dem Sinne, wie die Ordnung ein System der Wahrscheinlichkeit ist, das man in das System einführt, um dessen Verhalten voraussagen zu können. In der kinetischen Gastheorie nimmt man einen in zwei Abschnitte geteilten Behälter mit einer Verbindung zwischen zwei Abschnitten an und postuliert dann rein theoretisch die Existenz eines als Maxwellscher Dämon [☞ 2] bezeichneten Apparats, der es den schnelleren Gaspartikeln gestatten würde, in den einen Abschnitt zu fliegen, und den langsameren, im anderen zu bleiben: dergestalt würde ein Ordnungsprinzip in das System eingeführt und die Möglichkeit zur Voraussage einer thermischen Differenzierung gegeben; in Wirklichkeit existiert dieser Dämon nicht, und die Gasmoleküle gleichen bei ihrem ungeordneten Aufeinanderprallen ihre Geschwindigkeiten aus, was zu einem »mittleren« Zustand führt, der der statistischen Gleichwahrscheinlichkeit zustrebt: das System hat dann die höchste Entropie und man kann die Bewegung keines einzelnen Teilchens voraussehen.

Umberto Eco: Das offene Kunstwerk. Übers. v. Günter Memmert. Frankfurt/M.: Suhrkamp 51990, S. 99–101.

Wenn alle Buchstaben des Alphabets, die man auf einer Schreibmaschine schreiben kann, ein System höchster Entropie bilden, liegt ein Zustand größter Information vor. Einem Beispiel von Guilbaud folgend können wir nun sagen, daß, da eine Schreibmaschinenseite 25 Zeilen mit je 60 Spatien hat und die hier angenommene Schreibmaschine 42 Tasten – mit denen jeweils zwei Zeichen geschrieben werden können – besitzt, also, wenn man die Leertaste hinzurechnet (die den Wert eines Zeichens hat) 85 Zeichen schreiben kann, folgendes Problem entsteht: wenn 25 Zeilen zu je 60 Spatien 1500 Spatien ergeben, wie viele Folgen von 1500 Spatien lassen sich erzeugen, wenn man jedes der auf der Tatstatur verfügbaren 85 Zeichen verwendet?

Man erhält die Gesamtzahl der von einer Tastatur mit C Zeichen lieferbaren Botschaften von der Länge L, wenn man C in die L-te Potenz erhebt. In unserem Fall können wir also 851500 mögliche Botschaften erzeugen. Das ist der Wahrscheinlichkeitszustand an der Quelle; die möglichen Botschaften werden durch eine Zahl mit 2895 Ziffern ausgedrückt. Wie viele binäre Wahlen aber sind zur Feststellung einer der möglichen Botschaften erforderlich? Es würde sich eine riesige Zahl ergeben, was gleichbedeutend ist mit einem beträchtlichen Zeit- und Energieaufwand, um so mehr, als jede Botschaft, wie wir wissen, sich aus 1500 Spatien zusammensetzt und jedes dieser Zeichen durch binäre Wahlen aus den 85 Zeichen der Tastatur herausgesucht werden muß … die Information an der Quelle ist sehr groß, doch wird es außerordentlich schwierig, diese mögliche Information durch Formulierung einer vollständigen Botschaft zu übermitteln.

—–

☞ 1: Vgl. Norbert Wiener, Kybernetik, Düsseldorf-Wien, Econ 1963; C. E. Shannon, W. Weaver, The mathematical theory of information, Urbana 1949; Colin Cherry, On human communication, a.a.O.; A. G. Smith, ed., Communication and Culture (Teil 1), N. Y., Holt, Rinehart & Winston, 1966.

☞ 2: betr. Dämonen à la Maxwells (et al.) vgl. Markus Krajewski: Die Dämonen. Über Gehilfen in den Wissenschaften. In: Agenten und Agenturen. Archiv für Mediengeschichte. Weimar 2008, S. 39–51.